Исследователи из университета Северной Каролины продемонстрировали новый способ атаки на системы компьютерного зрения, позволяющий контролировать то, что «увидит» искусственный интеллект. Использованный метод под названием RisingAttacK оказался эффективным для манипулирования всеми наиболее широко используемыми системами компьютерного зрения.

RisingAttacK — это так называемая «состязательная атака» (adversarial attack), которая манипулирует данными, подаваемыми в систему ИИ. RisingAttacK состоит из серии операций, целью которых является внесение минимального количества изменений в изображение, которое позволит сбить с толку когнитивные способности ИИ. В результате ИИ может неправильно определить цвет светофора или поставить ошибочный диагноз по рентгеновскому снимку.

Сначала RisingAttacK идентифицирует все визуальные особенности изображения и пытается определить, какая из них наиболее важна для достижения цели атаки. Затем RisingAttacK вычисляет, насколько чувствительна система ИИ к изменениям найденных ключевых особенностей.

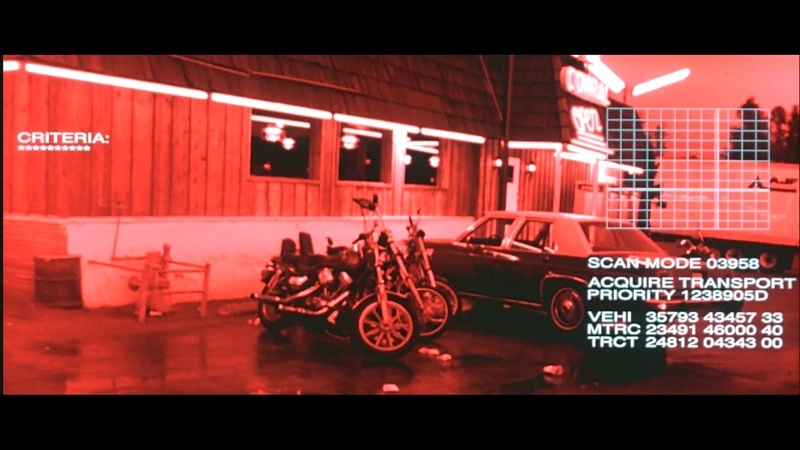

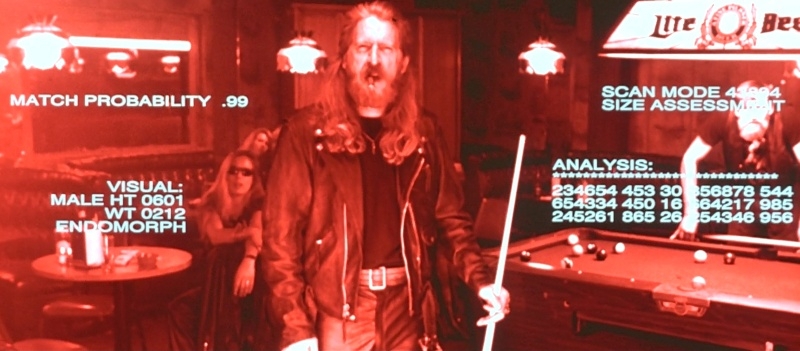

«Это требует некоторой вычислительной мощности, но позволяет нам вносить очень небольшие целенаправленные изменения в ключевые особенности, что делает атаку успешной, — рассказал доцент кафедры электротехники и вычислительной техники университета Северной Каролины Тяньфу Ву (Tianfu Wu). — В результате два изображения могут выглядеть одинаково для человеческого глаза, и мы можем чётко видеть машину на обоих изображениях. Но из-за RisingAttacK ИИ увидит машину на первом изображении, но не увидит на втором».

Исследователи протестировали метод RisingAttacK против четырёх наиболее часто используемых программ компьютерного зрения: ResNet-50, DenseNet-121, ViTB и DEiT-B. Метод оказался эффективным при манипулировании всеми четырьмя программами.

«Мы хотели найти эффективный способ взлома систем машинного зрения с ИИ, потому что эти системы часто используются в контекстах, которые могут повлиять на здоровье и безопасность человека — от автономных транспортных средств до медицинских технологий и приложений безопасности, — пояснил Ву. — Выявление уязвимостей является важным шагом в обеспечении безопасности этих систем».

«Хотя мы продемонстрировали способность RisingAttacK манипулировать моделями зрения, сейчас мы находимся в процессе определения того, насколько эффективен этот метод при атаке на другие системы искусственного интеллекта, такие как большие языковые модели. В дальнейшем наша цель состоит в разработке методов, которые могут успешно защищать от таких атак», — заключил он.

Исследовательская группа сделала код RisingAttacK общедоступным для изучения и тестирования.